Pipeline() 関数は、Transformer ライブラリの不可欠な部分です。これには、推論タスク、モデル、トークン化メカニズムなどを定義できるいくつかの入力が必要です。 Pipeline() 関数は、1 つまたは複数のテキストに対して NLP タスクを実行するために主に使用されます。入力に対して前処理を実行し、モデルに基づいて後処理を実行して、人間が判読できる出力と最高精度の正確な予測を生成します。

この記事では次の側面について説明します。

ハグ顔データセット ライブラリとは何ですか?

Hugging Face データセット ライブラリは、いくつかの公開データセットを含む API であり、それらをダウンロードする簡単な方法を提供します。このライブラリは、「 ピップ ' 指示。 Hugging Face ライブラリのデータセットをダウンロードしてインストールする実際のデモンストレーションについては、こちらにアクセスしてください。 Google Colab のリンク。 から複数のデータセットをダウンロードできます。 ハグ顔データセット ハブ。

Pipeline() 関数の機能の詳細については、この記事を参照してください。 Transformers で Pipeline() 関数を利用するにはどうすればよいですか? ”。

Hugging Face でデータセットにパイプラインを適用するにはどうすればよいですか?

Hugging Face は、1 行のコードを使用して簡単にインストールできるいくつかの異なる公開データセットを提供します。この記事では、これらのデータセットにパイプラインを適用する実践的なデモンストレーションを見ていきます。データセットにパイプラインを実装するには 2 つの方法があります。

方法 1: 反復法を使用する

Pipeline() 関数は、データセットとモデルに対して反復処理することもできます。この目的のために、以下の手順に従います。

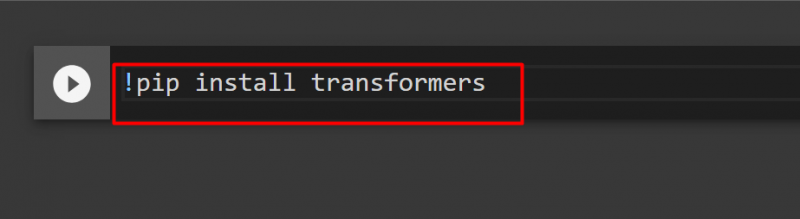

ステップ 1: Transformer ライブラリをインストールする

Transformer ライブラリをインストールするには、次のコマンドを入力します。

!pip トランスフォーマーをインストールする

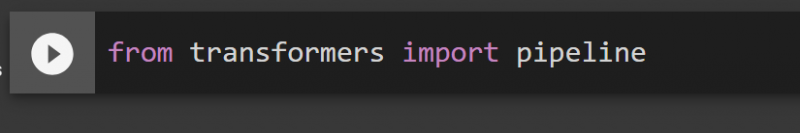

ステップ 2: パイプラインをインポートする

Transformer ライブラリからパイプラインをインポートできます。この目的のために、次のコマンドを提供します。

変圧器からのインポートパイプライン

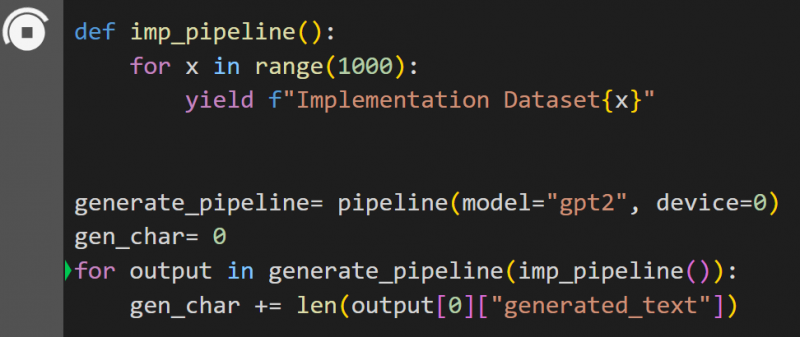

ステップ 3: パイプラインを実装する

ここでは、モデル「」に Pipeline() 関数が実装されています。 gpt2 ”。からモデルをダウンロードできます。 ハグフェイスモデルハブ:

def imp_pipeline():範囲 (1000) 内の x の場合:

yield f「実装データセット{x}」

generate_pipeline= パイプライン(モデル = 'gpt2'、デバイス = 0)

gen_char= 0

generate_pipeline(imp_pipeline()) の出力の場合:

gen_char += len(出力[0]['生成されたテキスト'])

このコードでは、「 パイプラインの生成 ” は、モデル” の Pipeline() 関数を含む変数です。 gpt2 ”。 「」で呼び出された場合 imp_pipeline() 」機能では、1000までの範囲を指定して増加したデータを自動認識します。

これにはトレーニングに時間がかかります。へのリンク グーグル社 も与えられます。

方法 2: データセット ライブラリを使用する

このメソッドでは、「datasets」ライブラリを使用してパイプラインを実装する方法を示します。

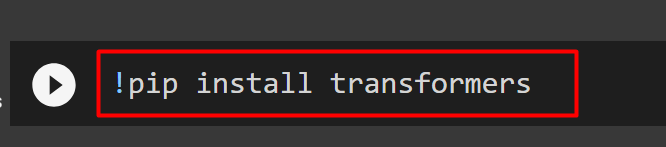

ステップ 1: 変圧器をインストールする

Transformer ライブラリをインストールするには、次のコマンドを入力します。

!pip トランスフォーマーをインストールする

ステップ 2: データセット ライブラリをインストールする

「」として データセット 」ライブラリにはすべての公開データセットが含まれているため、次のコマンドを使用してインストールできます。 「」をインストールすることで、 データセット 」ライブラリを使用すると、名前を指定して任意のデータセットを直接インポートできます。

!pip データセットをインストールする

ステップ 3: データセット パイプライン

データセット上にパイプラインを構築するには、次のコードを使用します。 KeyDataset は、ユーザーが関心のある値のみを出力する機能です。

Transformers.pipelines.pt_utils から KeyDataset をインポート変圧器からのインポートパイプライン

データセットからのインポートload_dataset

gen_pipeline = パイプライン(モデル = 'hf-internal-testing/tiny-random-wav2vec2', device=0)

gen_pipeline(KeyDataset(loaddataset, 'audio')) での出力用のloaddataset =load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]'):

print('出力を印刷中')

印刷 ('----------------')

print(出力)

上記のコードの出力は次のとおりです。

このガイドの説明は以上です。へのリンク グーグル社 この記事でも言及されています

結論

データセットにパイプラインを適用するには、pipeline() 関数を使用してデータセットを反復処理するか、「 データセット ' 図書館。 Hugging Face は、要件に基づいて使用できるデータセットとモデルの両方について、GitHub リポジトリ リンクをユーザーに提供します。この記事では、Transformers のデータセットにパイプラインを適用するための包括的なガイドを提供しました。