構文:

ChatGPT についてはよく知っているので、このプラットフォームは Open AI コミュニティによって所有されており、アプリケーションや自然言語処理モデルの展開に利用できるツール、アーキテクチャ、API、およびいくつかのフレームワークを提供していることはわかっています。 Open AI は、Open AI プラットフォームから事前トレーニングされた AI および NLP モデルを使用できる API を提供し、それらをアプリケーションで機能させ、たとえば、リアルタイム データの予測を行うことができます。同様に、GPT4All は、事前トレーニングされた AI モデルをさまざまなアプリケーションと統合することもユーザーに提供します。

GPT4All モデルは、ChatGPT と比較して限られたデータでトレーニングされます。 ChatGPT と比較するとパフォーマンス上の制約もありますが、ユーザーはローカル ハードウェア上でプライベート GPT を使用でき、ネットワーク接続は必要ありません。この記事の助けを借りて、GPT4All には Python との公式バインディングがあるため、Python スクリプトで GPT4All モデルを使用する方法を知ることができます。つまり、Python スクリプトを通じて GPT4All モデルを使用および統合することもできます。

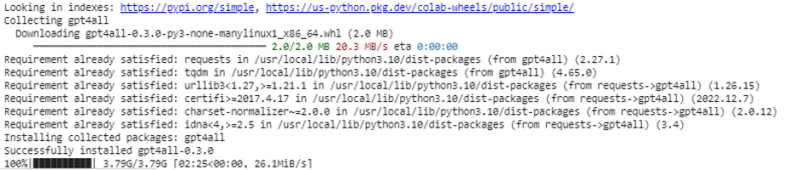

Python IDE 用の GPT4All をインストールするには、すべてオンライン コマンドが必要です。そうすれば、アプリケーションと同数の AI モデルを統合できるようになります。これを Python で GPT4All をインストールするコマンドは次のとおりです。

$ pip インストール gpt4all

例 1:

この例を開始するには、Python をダウンロードしてシステムにインストールする必要があります。 Python の推奨バージョンは「バージョン 3.7」以降です。 Python を使用してシステムに「Python セットアップ」をインストールする長いプロセスを回避するもう 1 つの方法は、Python のクラウドベース環境である「Google Colab」を使用することです。この環境は任意の Web ブラウザーで実行でき、AI および機械学習モデルを構築できます。ここで実装する例は、Google Colab で実行されます。

この例では、Python で GPT4All をインストールする方法と、事前トレーニングされたモデルの使用方法について説明します。まず GPT4All をインストールすることから始めます。そのために、前に説明したコマンドが実行されます。コマンドを実行すると、GPT4All とそのパッケージおよびフレームワークがダウンロードされ、インストールされます。

さあ、先に進みます。 GPT4All から、「GPT4All」をインポートします。これにより、GPT4All のすべての事前トレーニングされたモデルがプロジェクトに追加されます。ここで、任意の単一モデルを利用して、アプリケーションの予測を実行させることができます。 GPT4All パッケージをインポートしたら、この関数を呼び出して、「チャット完了」の出力を提供する GPT4All モデルを使用します。

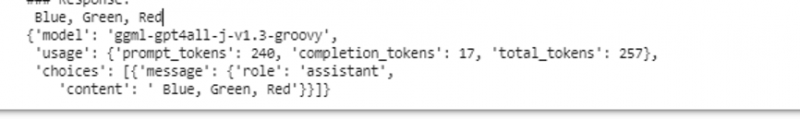

言い換えれば、入力でそのモデルに何かを要求すると、それが出力で返されます。ここで使用するモデルは「ggml-gpt4all-j-v1.3-groovy」です。これらのモデルはすでに GPT4All キャッシュに保存されています。これらのモデルはこのリンクから入手できます。 https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat 」を参照してマニュアルをダウンロードしてください。モデルが既に GPT4All キャッシュに存在する場合は、モデルの名前を呼び出して、それを「GPT4All()」関数への入力パラメーターとして指定するだけです。手動でダウンロードに成功した場合は、モデルが配置されているフォルダーへのパスを渡します。このモデルはメッセージ補完用であるため、このモデルの構文は次のようになります。

$ Chat_completion (メッセージ)メッセージは辞書リストであり、各辞書には、ユーザー、システム、またはアシスタントの値を持つ「役割」キーと、その値を文字列として持つ「キー」コンテンツが含まれている必要があります。この例では、コンテンツを「3 つの色の名前」として指定し、ロールキーを「user」として指定します。

$model= GPT4All('ggml-gpt4all-j-v1.3-groovy')$messages = [{'role': 'user', 'content': '花の名前を 3 つ'}]

この指定の後、モデルで「chat_completion()」関数を呼び出します。このコードは次の出力に表示されます。

$ !pip gpt4all をインストールgpt4all から GPT4All をインポート

モデル = GPT4All('ggml-gpt4all-j-v1.3-groovy')

messages = [{'role': 'user', 'content': '3 色の名前'}]

model.chat_completion(メッセージ)

この例の実行後、モデルは入力への応答として 3 色を返します。

例 2:

Python で GPT4All を使用する別の方法を発見する別の例を取り上げます。これは、オープンソース AI コミュニティである「Nomic」によって提供される Python の公式バインディングを使用して実行でき、GPT4All が実行されます。次のコマンドを使用して、「nomic」を Python コンソールに統合します。

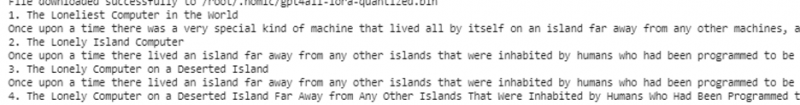

$ pip インストール nomicこれをインストールしたら、「nomic.gpt4all」から GPT4All をインポートします。 GPT4All をインポートした後、「open()」関数を使用して GPT4All を初期化します。次に、「prompt()」関数を呼び出し、この関数にプロンプトを渡します。次に、プロンプト モデルへの入力として指定したプロンプトに基づいて、プロンプト応答が生成されます。

!pip インストール nomicnomic.gpt4all から GPT4All をインポート

# GPT4All モデルを初期化する

開始 = GPT4All()

開始.open()

# プロンプトに基づいて応答を生成する

model_response =Initial.prompt('コンピュータに関する短い話を書いてください)

# 生成されたレスポンスを表示する

print(モデル応答)

出力には、Python で事前トレーニングされた GPT4All モデルを使用して生成したモデルからのプロンプト応答が表示されます。モデルと、これらのモデルを使用して応答を生成する方法についてさらに詳しく知りたい場合、または簡単に言えば、これらのモデルから応答を生成するための構文についての知識を得たい場合は、 GPT4All の技術文書の詳細。

結論

GPT4All は、パフォーマンスの精度を得るために引き続き努力しています。 GPT4All はネットワーク接続や GPU なしで動作するため、消費者グレードの CPU でユーザーに人工知能チャットボットを提供することを目的とした nomic AI プラットフォームによって実行されます。この記事では、Python 環境で PyGPT4All を上手に使用し、アプリケーションと事前トレーニングされた GPT4All AI モデルの間の相互作用を作成する方法を説明します。このガイドでは、Python に GPT4All をインストールする 2 つの異なる方法について説明しました。