個々のデータエントリは「 テンソル PyTorch の「」と「 グラデーション テンソルの「」は、深層学習モデルのトレーニング ループ内で逆伝播を使用して計算されます。用語 ' スケールなし 」は、データが生データであり、前処理や最適化が含まれていないことを意味します。 Tensor のスケーリングされていない勾配は、指定された損失関数に関する変化の真の値を提供します。

このブログでは、PyTorch で Tensor のスケールされていない勾配を計算する方法について説明します。

PyTorch のテンソルのスケールなし勾配とは何ですか?

Tensor はデータを含む多次元配列であり、PyTorch の GPU 上で実行できます。前処理、変換、最適化を行わずにデータセットからの生データを含むテンソルは、スケーリングされていないテンソルと呼ばれます。ただし、「 スケールなしのグラデーション 」はスケーリングされていないテンソルとは異なるため、この 2 つを混同しないように注意する必要があります。テンソルのスケーリングされていない勾配は、選択した損失関数に関して計算され、それ以上の最適化やスケーリングは行われません。

PyTorch でテンソルのスケールされていない勾配を計算するにはどうすればよいですか?

テンソルのスケーリングされていない勾配は、選択された損失関数に関する入力データの変化率の実際の値です。生の勾配データは、トレーニング ループ中のモデルの動作とその進行を理解するために重要です。

PyTorch でテンソルのスケーリングされていない勾配を計算する方法を学習するには、以下の手順に従ってください。

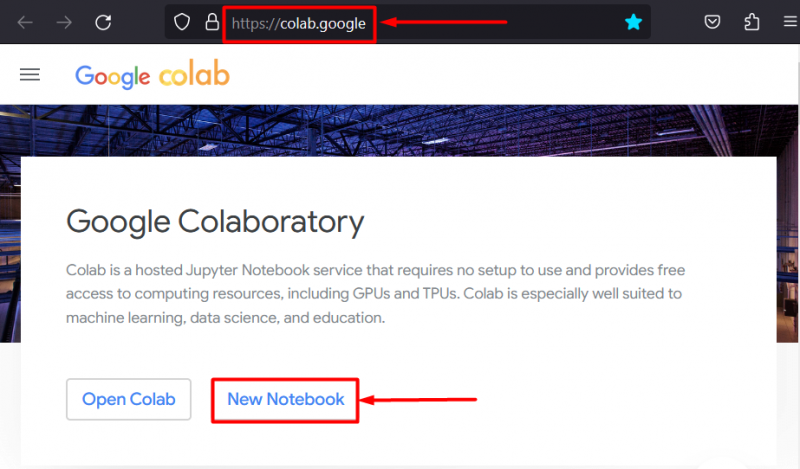

ステップ 1: IDE をセットアップしてプロジェクトを開始する

Google Colaboratory IDE は、GPU に無料でアクセスして処理を高速化できるため、PyTorch プロジェクトの開発に最適な選択肢の 1 つです。コラボに行く Webサイト そして「」をクリックします 新しいノートブック 」オプションを使用して作業を開始します。

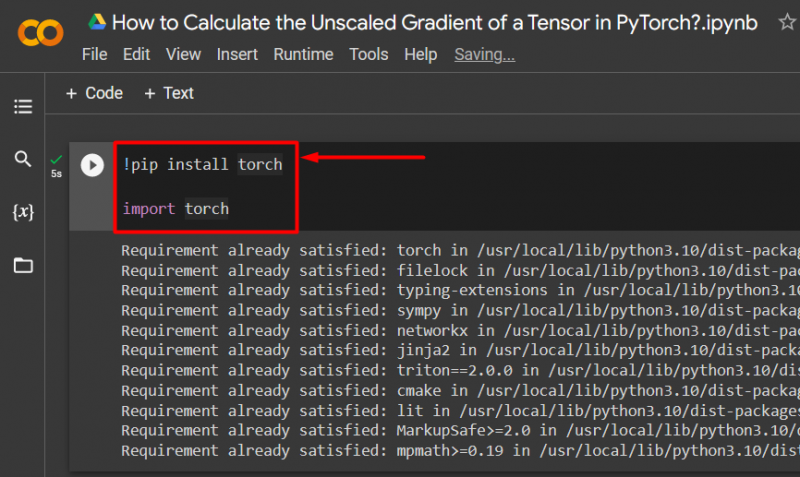

ステップ 2: エッセンシャルトーチランプライブラリをインポートする

PyTorch フレームワークのすべての機能は、「 松明 ' 図書館。すべての PyTorch プロジェクトは、このライブラリをインストールしてインポートすることから始まります。

!pip インストールトーチ輸入トーチ

上記のコードは次のように動作します。

- 「! ピップ 」は、プロジェクトにライブラリをインストールするために使用される Python のインストール パッケージです。

- ” 輸入 」コマンドは、インストールされているライブラリをプロジェクトに呼び出すために使用されます。

- このプロジェクトには「」の機能のみが必要です。 松明 ' 図書館:

ステップ 3: 勾配を使用して PyTorch Tensor を定義する

使用 ' トーチ.テンソル ()' 勾配のあるテンソルを定義するメソッド ' Required_grad=True ' 方法:

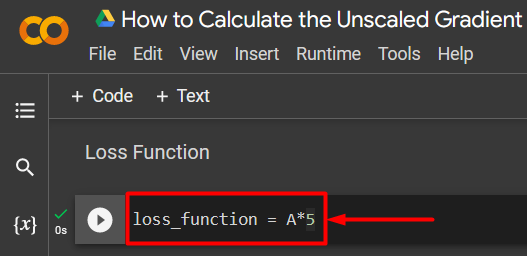

A = torch.tensor([5.0]、requires_grad=True)ステップ 4: 単純な損失関数を定義する

損失関数は、次のような単純な算術方程式を使用して定義されます。

損失関数 = A*5

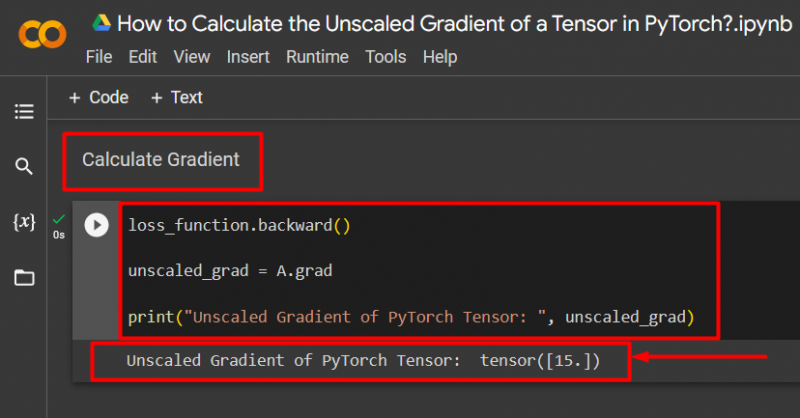

ステップ 5: グラデーションを計算して印刷して出力する

使用 ' 後ろ向き ()」メソッドを使用して、次のようにスケールなしの勾配を計算します。

loss_function.backward()unscaled_grad = A.grad

print('PyTorch Tensor のスケールされていない勾配: ', unscaled_grad)

上記のコードは次のように動作します。

- 使用 ' 後ろ向き ()」メソッドを使用して、逆方向伝播を介してスケールなしの勾配を計算します。

- 「」を割り当てます 卒業生 ”へ” unscaled_grad ' 変数。

- 最後に「」を使用します。 印刷する ()」メソッドを使用して、スケーリングされていないグラデーションの出力を表示します。

注記 : ここから Colab ノートブックにアクセスできます リンク 。

プロのヒント

テンソルのスケーリングされていない勾配は、PyTorch フレームワーク内のニューラル ネットワークの損失関数と入力データの正確な関係を示すことができます。未編集の生のグラデーションは、両方の値が体系的にどのように関連しているかを示しています。

成功! PyTorch でテンソルのスケーリングされていない勾配を計算する方法を示しました。

結論

PyTorch でテンソルのスケーリングされていない勾配を計算するには、最初にテンソルを定義し、次に、backward() メソッドを使用して勾配を見つけます。これは、深層学習モデルが入力データと定義された損失関数をどのように関連付けるかを示しています。このブログでは、PyTorch でテンソルのスケーリングされていない勾配を計算する方法について段階的なチュートリアルを提供しました。