Python と Pandas を使用したデータのクリーニング

データは今日の意思決定の構成要素のようなものです。しかし、このコレクションのさまざまな形やサイズのブロックのグループがあると想像してください。意味のあるものを構築するのは難しい。ここでデータ クリーニングが役に立ちます。

このガイドでは、より良い意思決定を行うために、Python のフレームワーク (Pandas) を使用してデータをクリーンアップする方法を説明します。店舗の販売記録のリストを扱うことを考えると、データのクリーニングも不可欠です。リスト内に欠落している番号、奇妙な日付、理由もなく繰り返される項目があることに気づく場合があります。この情報に基づいて計算や記録を行うと、これらの問題により計算や予測が台無しになる可能性があります。データ クリーニングはこれらの問題を解決し、データが正確ですぐに使用できるようにするのに役立ちます。

データ クリーニングには、欠落データの処理と一部のデータが欠落した場合の対処方法、重複の削除、コピーされたものの削除、データ型の修正、すべてが適切な形式であることの確認、外れ値の処理や数値の処理が含まれます。これらの間違いにより、データが同じように見え、データの表示方法が標準化されてしまいます。

始めるには、まず Python と Pandas がインストールされていることを確認してください。これを行うには、コンピュータのターミナルまたはコマンド プロンプトにコマンドを入力します。このガイドで説明されているコードを実装するには、システムにインストールされている Python Pycharm IDE またはオンライン Python プラットフォームである「Google Colab」を使用し、「pip」コマンドをインストールして重要なライブラリをインストールします。

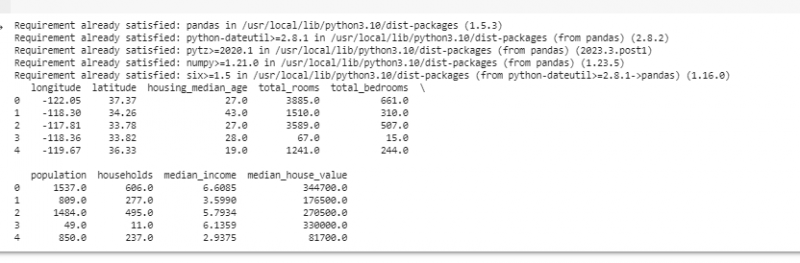

次に、Pandas をインポートしてサンプル データをロードしましょう。この例では、Google Colab を使用してコードを実行します。したがって、最初に次のコマンドを入力して Pandas をインポートします。

! pip インストールパンダ

輸入 パンダ として PD

輸入 しびれる として 例えば

次に、ファイル パスを入力パラメーターとして受け取る pd.read() メソッドを使用して、表示するデータセットを読み込みます。

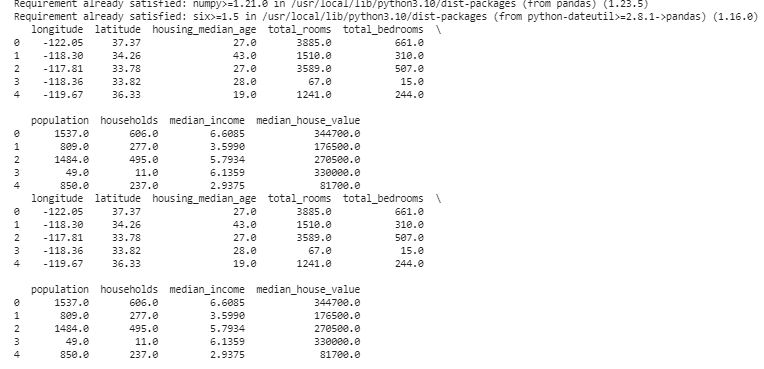

# データセットをロードするデータ = PD。 read_csv ( '/content/sample_data/california_housing_test.csv' )

# 最初の数行を表示する

印刷する ( データ。 頭 ( ) )

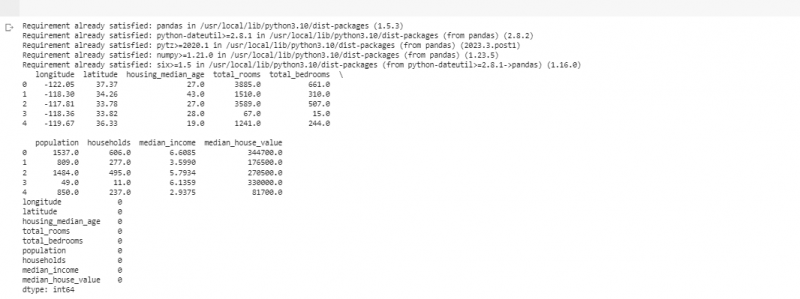

次の例では、小規模店舗の売上に関するデータを使用します。欠落データを処理するために、データに情報が欠落している場合があります。これらの欠損部分を「NaN」(「数値ではない」という意味)と呼びます。 Python スクリプトでこれらの欠損値を見つけるには、前の例で行ったように、まずデータ セットを読み込みます。次に、「missing_values = data.isnull().sum()」関数を使用して、データセット内の欠損値を見つけます。この関数は、データセット内のすべての欠損値を検索します。次に、print() 関数を使用してそれらを表示します。

! pip インストールパンダ輸入 パンダ として PD

輸入 しびれる として 例えば

# データセットをロードする

データ = PD。 read_csv ( '/content/sample_data/california_housing_test.csv' )

# 最初の数行を表示する

印刷する ( データ。 頭 ( ) )

# 欠損値をチェックする

missing_values = データ。 無効である ( ) 。 和 ( )

# 欠損値の数を列ごとに表示します

印刷する ( missing_values )

前述のコードを実行する行で欠落データが見つかったら、それらの行には有用なデータがあまり含まれていないため、それらの行を削除できます。近くのポイントに基づいて時間ベースのデータを推定することで、欠損値を推測し、経験に基づいた推測で空白を埋めることもできます。

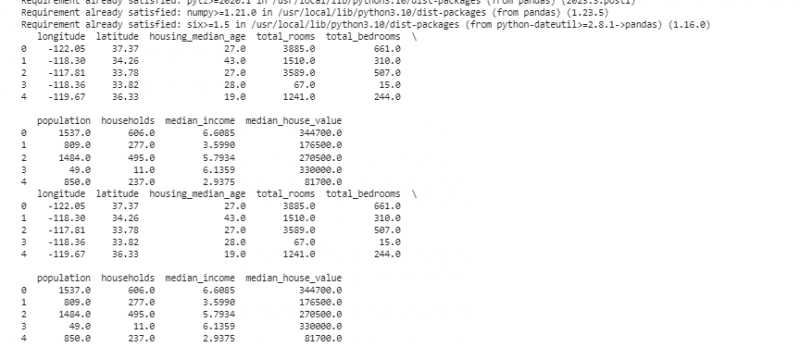

ここで、分析を混乱させる可能性があるため、同じもののコピーである重複を削除します。データセット内の重複する値を見つけるには、「duplicate_rows = data[data.duplicated()]」関数を使用します。これらの重複値を削除するには、data.drop_duplicates() 関数を呼び出します。次のコードを使用して、それらを見つけて削除できます。

! pip インストールパンダ輸入 パンダ として PD

輸入 しびれる として 例えば

# データセットをロードする

データ = PD。 read_csv ( '/content/sample_data/california_housing_test.csv' )

# 最初の数行を表示する

印刷する ( データ。 頭 ( ) )

# 重複行をチェックする

重複行 = データ [ データ。 重複した ( ) 】

# 重複を削除

データ = データ。 ドロップ_重複 ( )

# 重複を削除した後、最初の数行を表示します

印刷する ( データ。 頭 ( ) )

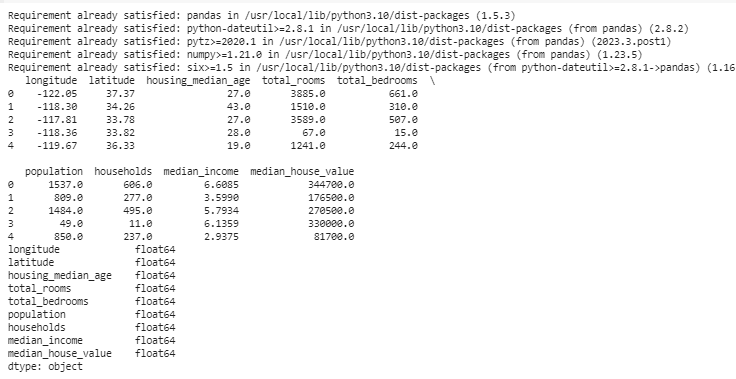

データ型は、データ型を固定するためにどのようなデータを保存できるかを決定します。データの種類ごとに適切な型を用意することが重要です。たとえば、日付のデータ型は日時、数値は int、float などのデータ型である必要があります。データのデータ型を確認するには、「data.dtypes」関数を使用します。この機能は次のような方法で利用できます。

! pip インストールパンダ輸入 パンダ として PD

輸入 しこり として 例えば

# データセットをロードする

データ = PD。 read_csv ( '/content/sample_data/california_housing_test.csv' )

# 最初の数行を表示する

印刷する ( データ。 頭 ( ) )

# 各列のデータ型を確認する

データ型 = データ。 dtype

# 表示データ型

印刷する ( データ型 )

問題が見つかった場合は、Pandas を使用してデータ型を変更できます。たとえば、日付を日付形式に変換できます。 DataFrame の「dtypes」属性は、各列のデータ型に関する情報を提供します。データ型が一致しないことが判明した場合は、Pandas の astype() 関数を使用して列を目的の型に変換できます。

データ型の後に、他の値とは大きく異なる値である外れ値が発生することがあります。彼らは私たちの計算を台無しにする可能性があります。外れ値に対処するために、データ内に存在する値をしきい値と比較する「np.abs(stats.zscore(data))」Z スコア関数を使用する関数を定義します。このしきい値の範囲以外の値は外れ値とみなされます。 。 外れ値を見つけて処理する方法を見てみましょう。

! pip インストールパンダ輸入 パンダ として PD

輸入 しこり として 例えば

# データセットをロードする

データ = PD。 read_csv ( '/content/sample_data/california_housing_test.csv' )

# 最初の数行を表示する

印刷する ( データ。 頭 ( ) )

から サイピー 輸入 統計

確かに 異常値の検出 ( データ ) :

z_スコア = 例えば 腹筋 ( 統計。 zスコア ( データ ) )

戻る 例えば どこ ( z_スコア > 3 )

# 「Sales」列の外れ値を検出して処理する

外れ値 = 異常値の検出 ( データ [ '経度' ] )

データ [ '経度' ] 。 場所 [ 外れ値 ] = データ [ '経度' ] 。 中央値 ( )

# 「販売個数」列の外れ値を検出して処理する

外れ値 = 異常値の検出 ( データ [ '緯度' ] )

データ [ '緯度' ] 。 場所 [ 外れ値 ] = データ [ '緯度' ] 。 中央値 ( )

# 外れ値を処理した後、最初の数行を表示します

印刷する ( データ。 頭 ( ) )

簡単な方法を使用して、前のコードの外れ値を見つけて修正します。これには、データの極値を中間値に置き換えることが含まれます。このコードは、Z スコア法を使用して、データセットの「経度」列と「緯度」列の外れ値を検出します。外れ値は、それぞれの列の中央値に置き換えられます。

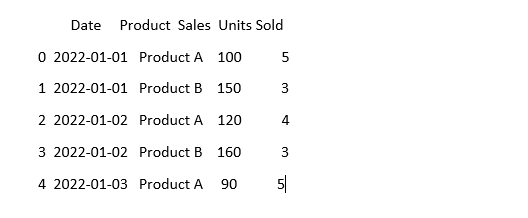

データを同じように見せるために、同じことを意味するデータであっても、異なるように見えることがあります。たとえば、日付はさまざまな形式で書き込むことができます。標準化には、一貫したデータ形式と表現を保証することが含まれます。これには、日付の書式設定、テキストの小文字への変換、数値の正規化などが含まれます。データセットの「日付」列を標準化し、データが同じに見えることを確認しましょう。

輸入 パンダ として PD輸入 しこり として 例えば # numpyをインポートする

# データをロードする

データ = PD。 read_csv ( 「売上データ.csv」 )

# 「日付」列の見た目に一貫性を持たせる

データ [ '日付' ] = PD。 to_datetime ( データ [ '日付' ] )

#今どうなっているか見てみましょう

印刷する ( データ。 頭 ( ) )

この例では、「pd.to_datetime(data[‘Date’])」関数を使用して、データセット内の日付形式を Python の日時形式に標準化します。 「日付」列を同じ形式に変換することで、このデータの操作が容易になります。出力には、データセットの最初の数行が標準化された「日付」列とともに表示されます。

結論

Python と Pandas を使用したデータ クリーニングの過程で、分析用にデータを改善する方法を学びました。私たちは、データのクリーニングがなぜそれほど重要なのかを理解することから始めました。それは私たちがより良い意思決定をするのに役立ちます。データの欠落に対処し、重複を削除し、データ型を修正し、外れ値を処理し、データを同じように見せる方法を検討しました。これらのスキルがあれば、乱雑なデータを信頼できるデータに変換し、重要な情報を発見するために使用できるようになります。データ クリーニングは部屋を整理整頓するのと同じように継続的なプロセスであり、データ分析をより成功させることができます。